DeepSeek R1 로컬(Local) 설치 가이드

최근 AI 챗봇의 데이터 보안 문제가 중요한 이슈로 부각되고 있습니다. DeepSeek AI의 프라이버시 정책에 따르면, 웹 서비스나 앱을 통해 사용할 경우 개인정보, 사용 패턴, 디바이스 정보 등 광범위한 데이터를 수집하며, 이 정보들은 중국 서버에 저장됩니다.

수집되는 정보의 범위:

- 개인 프로필 정보 (이름, 이메일, 전화번호)

- 채팅 기록 및 업로드한 파일

- 디바이스 정보 (모델명, 운영체제)

- 네트워크 정보 (IP 주소)

- 키보드 입력 패턴

- 시스템 언어 설정

하지만 DeepSeek R1을 로컬 환경에서 실행하면 이러한 걱정 없이 AI 챗봇을 활용할 수 있습니다. 이 글에서는 DeepSeek R1을 로컬 컴퓨터에 설치하고 실행하는 방법을 자세히 알아보겠습니다.

1. 설치 준비하기

1.1 Ollama 설치

Ollama는 AI 모델을 로컬 환경에서 실행하기 위한 기본 프로그램입니다.

# Windows의 경우 PowerShell 관리자 권한으로 실행 winget install ollama # macOS의 경우 brew install ollama # Linux의 경우 curl -fsSL https://ollama.com/install.sh | sh

1.2. Docker 설치

OpenWebUI 실행을 위해 필요한 컨테이너 플랫폼입니다.

# Windows/macOS: Docker Desktop 설치 후 실행 확인 docker --version

2. 본격적인 설치 과정

2.1 Ollama 서비스 시작

ollama serve2.2 OpenWebUI 설치

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main이 명령어를 실행하면 다음과 같은 과정이 진행됩니다.

- Docker 이미지 다운로드 (처음 실행 시에만)

- 컨테이너 생성 및 네트워크 설정

- 데이터 저장을 위한 볼륨 생성

- 웹 서버 시작

전체 설치 과정은 인터넷 속도에 따라 1-2분 정도 소요됩니다. 설치가 완료되면 Docker Desktop의 Containers 탭에서 'open-webui' 컨테이너가 실행 중인 것을 확인할 수 있습니다.

설치 상태 확인을 위해 다음 명령어를 실행할 수 있습니다.

docker ps정상적으로 설치가 완료되면 'open-webui' 컨테이너가 목록에 표시됩니다.

2.3. DeepSeek R1 모델 설치

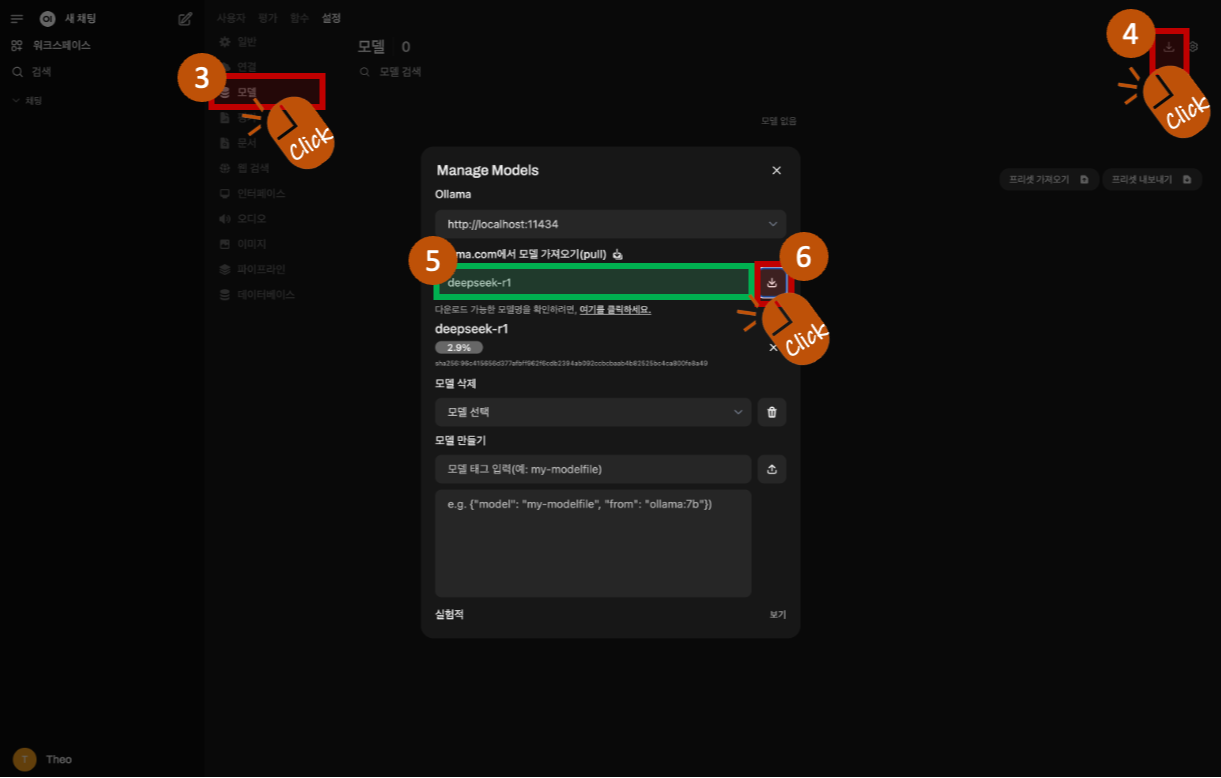

브라우저에서 localhost:3000 접속합니다.

우측 상단에서 설정을 클릭하고 팝업화면에서 관리자 설정을 클릭합니다.

모델 설정에서 Manage Models을 클릭하고 모델 태그명( deepseek-r1 )을 입력한 뒤 Download를 클릭하면 다운로드가 진행됩니다.

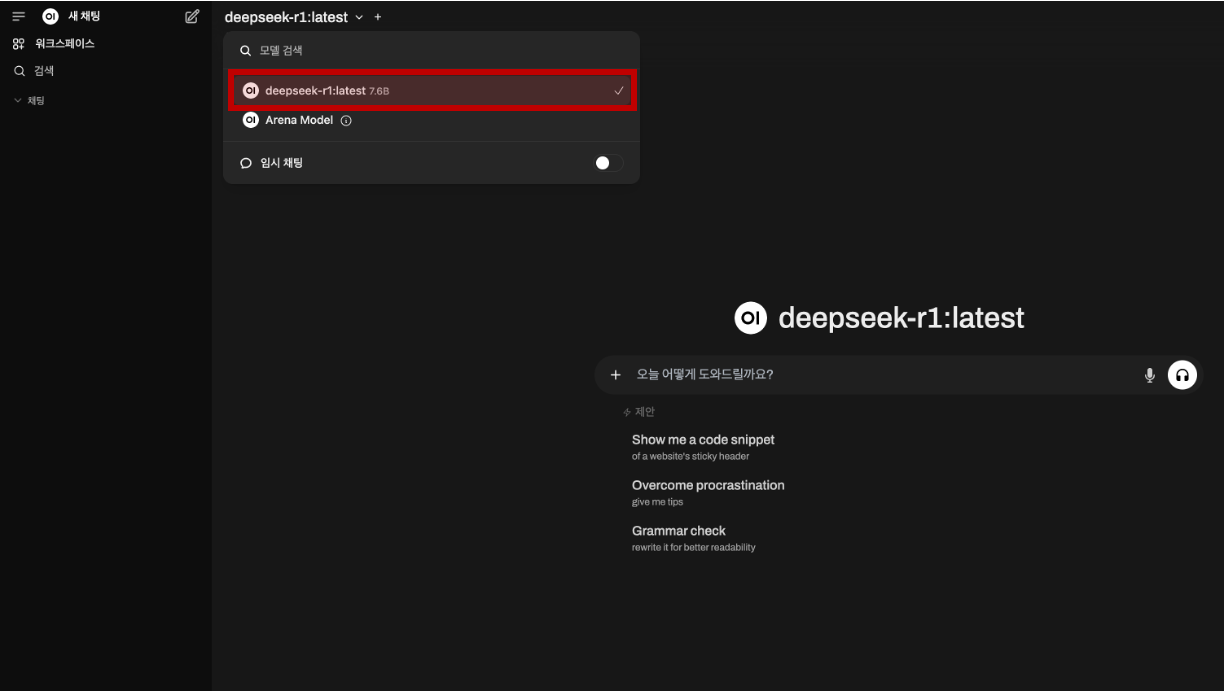

3. 모델 실행 및 사용

설치가 모두 완료되었다면, OpenWebUI 상단의 모델 드롭다운 메뉴에서 'deepseek-r1:latest 7.6B'가 표시되는 것을 확인할 수 있습니다.

DeepSeek R1 7.6B 모델은 약 4.7GB 크기로, Apple M3 Pro 칩셋이 탑재된 시스템에서도 원활하게 구동됩니다. 다만 실제 사용해 보니 영어는 가장 안정적인 성능을 보여주며, 응답의 정확도가 높습니다. 한국어는 기본적인 의사소통은 가능하나, 간혹 중국어가 혼용되어 출력되는 경우가 있습니다.

위에는 DeepSeek R1 7.6B 모델과의 실제 대화 내용입니다. 2등을 추월했을 때 몇 등이 되는지에 대한 논리적 추론 테스트를 진행했습니다. 테스트는 실제 Apple M3 Pro에서 수행되었으며, 실시간으로 촬영된 것으로, 모델의 실제 성능과 응답 속도를 있는 그대로 확인하실 수 있습니다.

최근 DeepSeek R1의 개발 비용과 데이터 보안에 대한 다양한 이야기가 있습니다. 실제 개발 비용은 공개된 것보다 더 많이 소요되었을 것으로 추정도 되고, 웹 서비스나 앱을 통한 사용 시 데이터 프라이버시 문제도 제기되고 있습니다.

하지만 DeepSeek R1의 가장 큰 의의는 오픈소스로 공개되었다는 점입니다. 이미 GitHub에서는 다양한 개발자들이 이를 기반으로 새로운 모델들을 만들어내고 있습니다. 더 작은 크기의 모델이나 특정 용도에 최적화된 버전 등 다양한 변형 모델들이 등장하고 있어, AI 발전의 새로운 전기가 될 것으로 기대됩니다.

제가 "경주에서 2등을 추월했다면 몇 등이 되는가?"라는 간단한 논리 퍼즐을 테스트해 봤는데... 흥미롭게도 모델이 5분 이상 '생각 중(Thinking)'이더군요. 결국 컴퓨터의 메모리를 계속 잡아먹으면서 다른 작업을 할 수 없는 상황이 되어 프로세스를 강제 종료할 수밖에 없었습니다.

이렇게 오래 생각할 문제였나 싶네요. 😅

'Tech & Development > AI' 카테고리의 다른 글

| AI로 시작하는 No-code 개발: MVP부터 프로토타입까지 (0) | 2025.01.28 |

|---|---|

| OpenAI, Sora(소라) 사용방법 가이드 (0) | 2024.12.13 |

| AWS Bedrock으로 구현한 Contextual Retrieval (0) | 2024.12.04 |

| Claude의 새로운 기능: 맞춤형 응답 스타일 설정 (0) | 2024.11.28 |

| Anthropic의 Model Context Protocol(MCP) : 사용 가이드 (0) | 2024.11.27 |

댓글

이 글 공유하기

다른 글

-

AI로 시작하는 No-code 개발: MVP부터 프로토타입까지

AI로 시작하는 No-code 개발: MVP부터 프로토타입까지

2025.01.28 -

OpenAI, Sora(소라) 사용방법 가이드

OpenAI, Sora(소라) 사용방법 가이드

2024.12.13 -

AWS Bedrock으로 구현한 Contextual Retrieval

AWS Bedrock으로 구현한 Contextual Retrieval

2024.12.04 -

Claude의 새로운 기능: 맞춤형 응답 스타일 설정

Claude의 새로운 기능: 맞춤형 응답 스타일 설정

2024.11.28

댓글을 사용할 수 없습니다.