2024 OpenAI DevDay 내용정리

2023년 OpenAI DevDay는 GPT-4 Turbo, GPTs, Assistants API, Retrieval, 그리고 Code Interpreter 등의 혁신적인 기술을 선보이며 AI 커뮤니티에 충격을 안겼습니다. 이러한 획기적인 발표들로 인해 2024년 DevDay에 대한 기대감 역시 매우 컸습니다.

2024년 10월 1일에 열린 OpenAI DevDay는 작년만큼 충격적인 발표는 없었지만, AI 기술의 지속적인 발전과 실용성 증대를 보여주는 여러 중요한 업데이트를 제공했습니다. 특히 개발자들과 기업들이 AI 기술을 더욱 효과적으로 활용할 수 있게 해주는 새로운 도구와 기능들이 소개되었습니다.

이번 DevDay에서 OpenAI가 발표한 주요 내용은 다음과 같습니다.

- 실시간 API (Real-time API)

- 비전 파인튜닝 (Vision Fine-tuning)

- 프롬프트 캐싱 (Prompt Caching)

- 모델 증류 (Model Distillation)

또한, 검색 시스템 개선과 구조화된 JSON 출력에 대한 상세한 정보도 공유되었습니다. 이러한 업데이트들은 AI 애플리케이션의 성능, 효율성, 그리고 다양성을 크게 향상시킬 것으로 기대됩니다.

각각의 주요 발표 내용에 대해 자세히 살펴보겠습니다.

#1. 실시간 API (Real-time API)

OpenAI DevDay 2024에서 가장 주목받은 발표 중 하나인 실시간 API는 개발자들에게 저지연, 멀티모달 경험을 구축할 수 있는 강력한 도구를 제공합니다. 이 기능은 ChatGPT의 고급 음성 모드와 유사한 자연스러운 음성 대화를 지원하며, 기존 API에서 이미 지원되던 6가지 프리셋 음성을 활용합니다.

주요 특징

- 저지연 음성 대화: 실시간 API는 자연스러운 대화 속도에 가까운 응답을 제공합니다.

- 멀티모달 지원: 텍스트와 음성 입력을 모두 처리하고, 텍스트나 음성으로 응답할 수 있습니다.

- 단일 API 호출: 복잡한 음성 처리 파이프라인을 단일 API 호출로 간소화합니다.

- 감정과 억양 보존: 기존 방식과 달리 음성의 감정, 강조, 억양을 유지합니다.

- 함수 호출 지원: 음성 지시에 따라 특정 작업을 수행하거나 추가 정보를 검색할 수 있습니다.

작동 방식

실시간 API는 WebSocket 연결을 통해 GPT-4o와 메시지를 교환합니다. 이 방식은 다음과 같은 이점을 제공합니다:

- 스트리밍 방식: 음성 입력과 출력을 직접 스트리밍하여 대화의 자연스러움을 향상시킵니다.

- 중단 처리: ChatGPT의 고급 음성 모드처럼 대화 중 중단을 자동으로 처리합니다.

- 컨텍스트 유지: 지속적인 연결을 통해 대화의 맥락을 유지합니다.

사용 사례 및 응용 분야

실시간 API는 다양한 분야에서 활용될 수 있습니다:

- 고객 지원: 자연스러운 대화형 고객 서비스 챗봇 구현

- 언어 학습: 실시간 언어 연습 및 발음 교정 도구 개발

- 음성 기반 가상 비서: 복잡한 작업을 수행하는 고급 음성 비서 시스템

- 접근성 향상: 시각 장애인을 위한 음성 기반 인터페이스 개발

- 자동차 내 음성 인터페이스: 안전한 운전을 위한 음성 제어 시스템

- 헬스케어: 정신 건강 지원 및 의료 상담을 위한 대화형 도구

- 비즈니스 생산성: 회의록 작성, 실시간 통역 등 업무 지원 도구

이러한 다양한 응용 분야에서 실시간 API는 사용자 경험을 크게 개선하고 새로운 서비스 창출의 기반이 될 것입니다.

가격 정책

실시간 API의 가격은 다음과 같습니다:

- 텍스트 입력: 100만 토큰당 $5

- 텍스트 출력: 100만 토큰당 $20

- 음성 입력: 100만 토큰당 $100 (약 $0.06/분)

- 음성 출력: 100만 토큰당 $200 (약 $0.24/분)

이 가격은 Chat Completions API의 오디오 기능에도 동일하게 적용됩니다. 가격이 상대적으로 높게 책정되어 있어(음성 입력 100만 토큰당 $100, 출력 100만 토큰당 $200) 초기 도입에는 제약이 있을 수 있습니다. 그러나 기술의 발전과 함께 가격이 점차 낮아질 것으로 예상됩니다.

안전성 및 개인정보 보호

OpenAI는 실시간 API의 안전한 사용을 위해 여러 층의 보호 장치를 마련했습니다:

- 자동 모니터링: API 남용 위험을 줄이기 위한 자동화된 모니터링 시스템

- 인간 검토: 플래그된 모델 입력과 출력에 대한 인간의 검토

- 안전성 평가: 자동화 및 인간 평가를 통한 GPT-4o의 철저한 안전성 검증

- 오디오 안전 인프라: ChatGPT의 고급 음성 모드에서 사용된 것과 동일한 안전 인프라 활용

개발자들은 사용자에게 AI와 상호작용하고 있음을 명확히 알려야 하며, OpenAI는 스팸이나 오해의 소지가 있는 사용을 엄격히 금지합니다.

향후 계획

OpenAI는 실시간 API의 지속적인 개선을 위해 다음과 같은 계획을 가지고 있습니다:

- 추가 모달리티: 비전과 비디오 지원 추가 예정

- 속도 제한 증가: 현재 Tier 5 개발자 기준 약 100개의 동시 세션에서 점진적으로 증가 예정

- 공식 SDK 지원: Python 및 Node.js SDK에 실시간 API 지원 통합 예정

- 프롬프트 캐싱: 이전 대화 내용을 할인된 가격으로 재처리할 수 있는 기능 추가 예정

- 확장된 모델 지원: 향후 버전에서 GPT-4o mini 지원 예정

이러한 발전은 실시간 API가 더욱 다양한 분야에서 활용될 수 있는 가능성을 열어주며, 개발자들에게 더욱 강력하고 유연한 도구를 제공할 것으로 기대됩니다.

#2. 비전 파인튜닝 (Vision Fine-tuning)

GPT-4의 비전 능력을 특정 작업에 맞게 미세 조정할 수 있는 기능이 추가되었습니다. 이는 컴퓨터 비전 분야에 큰 영향을 미칠 것으로 보입니다.

주요 특징

- GPT-4o1 모델에 이미지와 텍스트를 함께 사용한 파인튜닝 가능

- 최소 100개의 이미지로도 성능 향상 가능

- 더 큰 규모의 텍스트와 이미지 데이터로 더 높은 성능 달성 가능

작동 방식

- 개발자가 이미지 데이터셋을 준비하고 플랫폼에 업로드

- 텍스트 파인튜닝과 유사한 프로세스로 진행

- JSON 형식으로 데이터 구조화 (시스템 메시지, 사용자 입력, 이미지 URL, 응답 등 포함)

사용 사례

- Grab (라이드셰어링 기업):

- 도로 이미지에서 교통 표지판 인식 및 차선 수 계산

- 차선 수 정확도 20%, 속도 제한 표지판 위치 파악 13% 향상

- Automat (기업 자동화):

- UI 요소 위치 파악 성공률 16.60%에서 61.67%로 향상

- 보험 문서 정보 추출 작업 F1 점수 7% 향상

- Coframe (디지털 콘텐츠 생성):

- 웹사이트 스타일 일관성 및 레이아웃 정확도 26% 향상

가격 정책

- 2024년 10월 31일까지 하루 100만 학습 토큰 무료 제공

- 이후 가격:

- 학습: 100만 토큰당 $25

- 추론: 입력 100만 토큰당 $3.75, 출력 100만 토큰당 $15

- 이미지 입력은 크기에 따라 토큰화 후 텍스트와 동일한 가격 적용

안전성 및 개인정보 보호

- 자동화된 안전성 평가 지속 실행

- 기업 개인정보 보호 정책 적용

- 파인튜닝된 모델은 개발자의 완전한 통제 하에 있음

이 기능은 현재 모든 유료 개발자들에게 제공되며, 최신 GPT-4o 모델 스냅샷(gpt-4o-2024-08-06)에서 지원됩니다.

저는 LaVague라는 UI 자동화 테스트 툴을 만드는 오픈소스 프로젝트에 참여한 경험이 있습니다. 이 프로젝트에서 우리는 LLM을 사용하여 UI 컴포넌트 요소를 찾고 Selenium으로 테스트를 수행하는 방식을 사용했습니다. 그 과정에서 UI 요소의 정확한 위치를 찾는 것이 가장 큰 난제 중 하나였습니다.

개인적으로 Automat의 사례에서 보여주는 UI 요소 위치 파악 성공률의 극적인 향상(16.60%에서 61.67%로)은 정말 놀랍습니다. 이는 우리가 LaVague 프로젝트에서 겪었던 어려움을 대부분 해결할 수 있는 수준의 발전입니다. 이러한 기술이 실제 프로젝트에 적용된다면, UI 자동화 테스트의 정확성과 효율성이 크게 향상될 것으로 기대됩니다.

#3. 프롬프트 캐싱 (Prompt Caching)

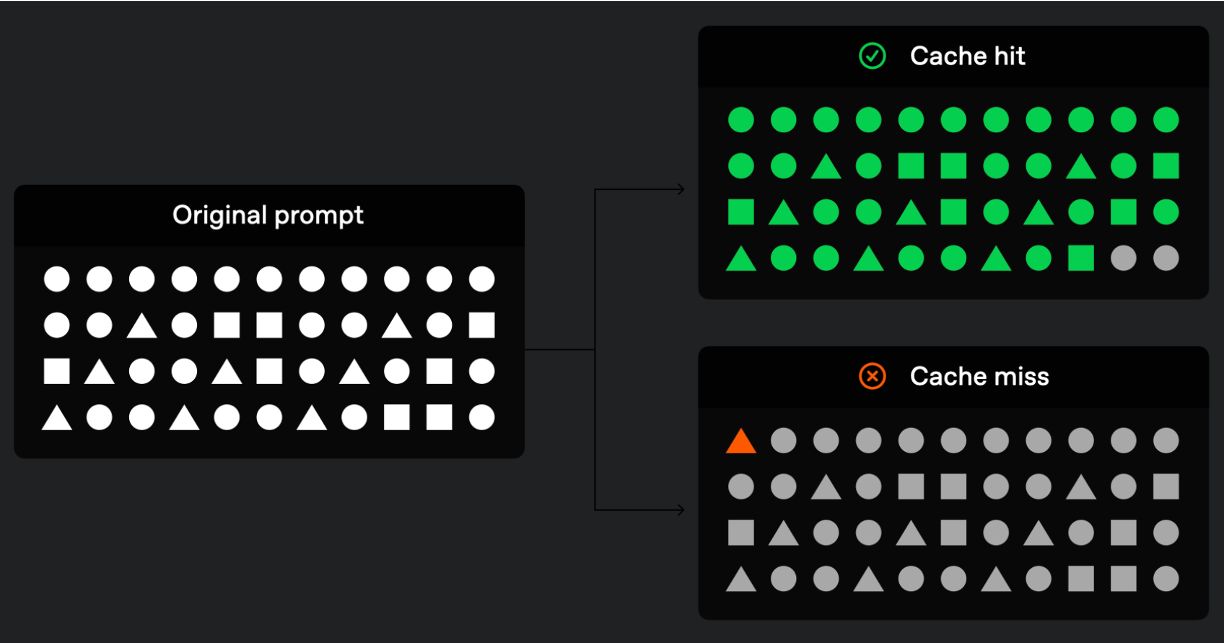

프롬프트 캐싱은 API 호출의 효율성을 크게 향상시킬 수 있는 기능입니다. 이는 Google과 Anthropic이 이미 도입한 기능이지만, OpenAI의 구현 방식은 약간 다릅니다.

프롬프트 캐싱 비교: OpenAI vs Google vs Anthropic

| 특징 | OpenAI | Anthropic | |

| 자동화 수준 | 1,024 토큰 이상 자동 적용 | 개발자가 명시적 지정 | 개발자가 명시적 지정 |

| 캐싱 단위 | 128 토큰 단위로 증가 | 개발자 지정 | 개발자 지정 |

| 비용 모델 | 캐시된 토큰 50% 할인 | 캐시된 프롬프트에 저렴한 요금 | 캐시된 프롬프트 무료 |

| 유연성 | 상대적으로 낮음 | 높음 | 높음 |

| 사용 편의성 | 매우 높음 (자동 적용) | 중간 (초기 설정 필요) | 중간 (초기 설정 필요) |

| 모니터링 | API 응답에 자동 포함 | 개발자가 직접 추적 필요 | 개발자가 직접 추적 필요 |

주요 차이점

- OpenAI는 사용 편의성과 자동화에 중점을 두어 개발자의 추가 작업 없이 비용 절감 효과를 제공합니다.

- Google과 Anthropic은 더 세밀한 제어를 제공하여 특정 사용 사례에 최적화할 수 있는 유연성을 제공합니다.

- 비용 모델에서 OpenAI는 할인 방식, Google은 저렴한 요금 부과, Anthropic은 무료 제공으로 각각 다른 접근을 취합니다.

각 접근 방식은 고유한 장단점을 가지고 있어, 개발자는 자신의 프로젝트 요구사항에 가장 적합한 방식을 선택할 수 있습니다.

주요 특징

- 반복적으로 사용되는 컨텍스트에 대해 비용과 지연 시간 감소

- 최근에 본 입력 토큰을 재사용하여 50% 할인 및 빠른 처리 시간 제공

적용 모델

- GPT-4o, GPT-4o mini, o1-preview, o1-mini의 최신 버전

- 위 모델들의 파인튜닝 버전에도 적용

가격 정책

- 캐시된 입력 토큰은 캐시되지 않은 토큰의 절반 가격으로 제공

- 예시:

- GPT-4o: 캐시 안 된 토큰 $2.50 → 캐시된 토큰 $1.25 (1M 토큰당)

- o1-preview: 캐시 안 된 토큰 $15.00 → 캐시된 토큰 $7.50 (1M 토큰당)

사용 및 모니터링

- 1,024 토큰 이상의 프롬프트에 자동으로 적용

- 128 토큰 단위로 증가하며 이전에 계산된 가장 긴 접두사를 캐시

- API 응답의

usage필드 내cached_tokens값으로 캐시 사용량 확인 가능

주의사항

- 캐시는 비활성 상태 5-10분 후 일반적으로 삭제되며, 최대 1시간 후 반드시 제거

- 조직 간 프롬프트 캐시 공유되지 않음

- 기업 개인정보 보호 정책 적용

프롬프트 캐싱은 개발자들이 성능, 비용, 지연 시간을 균형있게 조절하며 애플리케이션을 확장할 수 있게 해주는 유용한 도구입니다. 특히 코드베이스 편집이나 챗봇과의 장기 대화 등 반복적인 컨텍스트를 사용하는 AI 애플리케이션 개발에 큰 도움이 될 것으로 기대됩니다.

#4. OpenAI Model Distillation

모델 증류는 대규모 모델의 성능을 유지하면서 더 작고 효율적인 모델을 만드는 기술입니다.

주요 특징

- 고성능 모델의 출력을 사용해 소형 모델의 성능을 향상시키는 통합 워크플로우

- OpenAI 플랫폼 내에서 전체 distillation 파이프라인 관리 가능

- 특정 작업에 대해 고급 모델의 성능을 더 저렴한 비용으로 구현

구성 요소

- Stored Completions:

- 모델 출력 자동 캡처 및 저장

- 프로덕션 데이터로 데이터셋 구축 가능

- Evals (베타):

- 커스텀 평가 생성 및 실행

- 모델 성능 측정을 위한 통합 도구

- Fine-tuning:

- Stored Completions와 Evals를 기존 fine-tuning과 통합

사용 방법

- Evals를 사용해 distill할 모델의 초기 성능 평가

- Stored Completions로 실제 사례 기반 distillation 데이터셋 생성

- 생성된 데이터셋으로 목표 모델(예: GPT-4o mini) fine-tuning

- Evals로 fine-tuning된 모델의 성능 테스트

- 필요시 과정 반복하여 모델 성능 개선

가격 정책

- 2024년 10월 31일까지 GPT-4o mini에 일 2M, GPT-4o에 일 1M 무료 학습 토큰 제공

- Stored Completions 무료 제공

- Evals는 표준 모델 가격으로 책정, 연말까지 주당 7회까지 무료 평가 가능 (OpenAI와 공유 시)

Model Distillation은 모든 개발자가 사용 가능하며, GPT-4o와 o1-preview를 포함한 모든 OpenAI 모델에 적용할 수 있습니다. 이 기능을 통해 개발자들은 고성능 모델의 능력을 활용하면서도 비용 효율적인 AI 솔루션을 개발할 수 있습니다.

#5. 추가 발표 사항

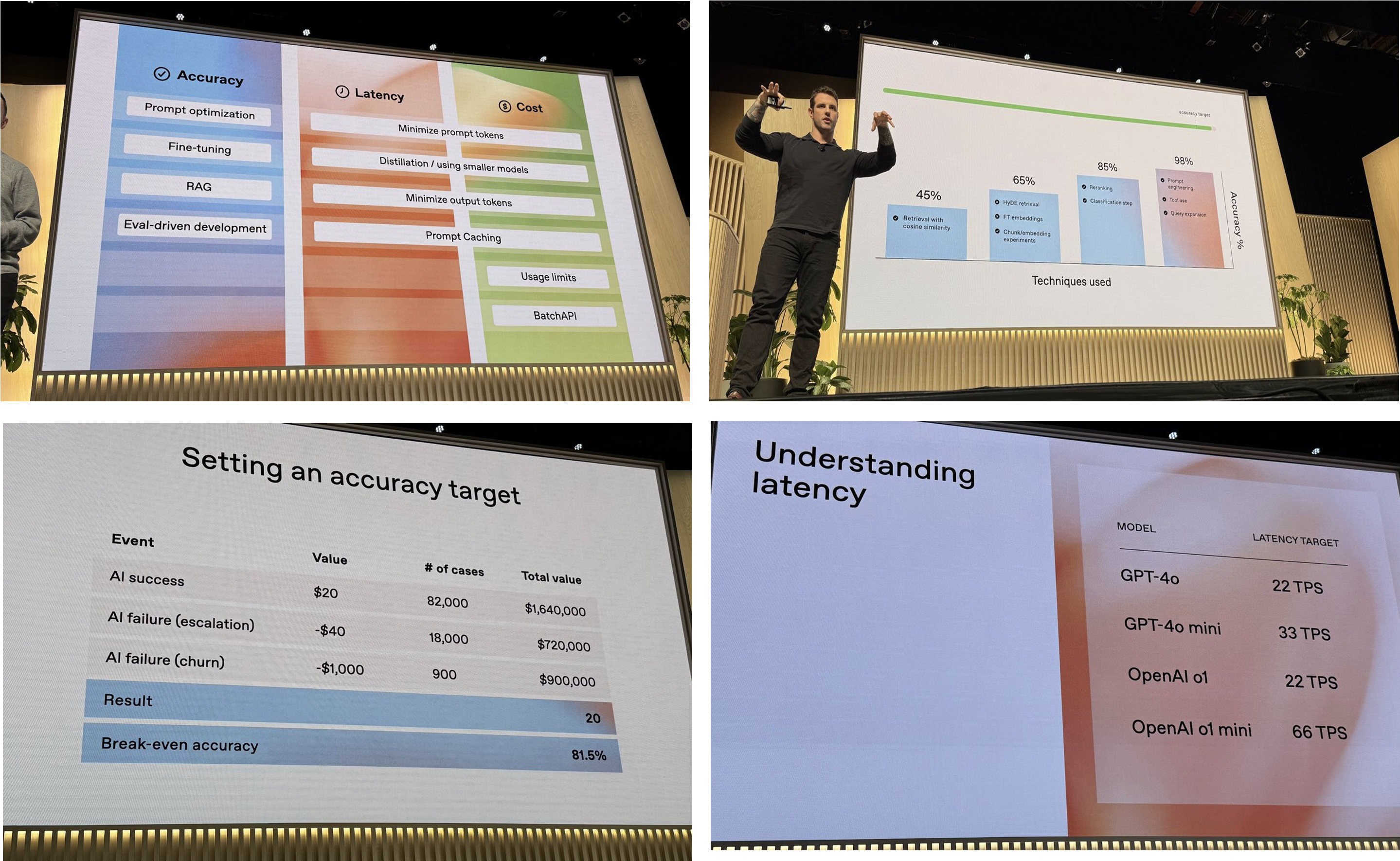

이외에도 추가적인 발표가 있었습니다. OpenAI는 LLM 앱을 1천 명에서 1천만 명의 사용자로 확장하는 방법에 대한 세션을 진행했고 검색 시스템 개선에 대한 상세한 정보를 공유했습니다.

개선된 검색 시스템

- 정확도 최적화

- 가장 지능적인 모델로 시작하여 정확도 최적화

- 평가(Eval) 구축 > 목표 설정 > 최적화 순서로 진행

- 객관적인 목표 설정의 중요성 강조

- 컴포넌트별 및 엔드투엔드 평가 구현 권장

- 성능 개선 기법

- 프롬프트 엔지니어링, RAG, 파인튜닝, 메타 프롬프팅 활용

- 검색 기법: 코사인 유사도, HyDE, 청킹, 리랭킹, 분류 단계, 도구 사용, 쿼리 확장

- 지연 시간 최적화

- 네트워크 지연, 입력 토큰 지연, 출력 토큰 지연 고려

- 짧은 프롬프트, 작은 모델, 프롬프트 캐싱 활용 권장

- 비용 최적화

- 프롬프트 캐싱으로 50% 비용 절감 (캐시 수명 5-10분, 최대 1시간)

- 배치 API 사용으로 대량 요청 처리 최적화

- 비피크 시간 활용 추천

이러한 가이드라인은 개발자들이 LLM 앱의 성능을 개선하고, 더 많은 사용자를 효율적으로 지원할 수 있도록 돕는 것을 목표로 합니다.

구조화된 JSON 출력

OpenAI는 구조화된 JSON 출력을 생성하는 방법에 대해 자세히 설명했습니다. 이는 AI 모델의 출력을 보다 정확하고 예측 가능하게 만드는 데 중요합니다.

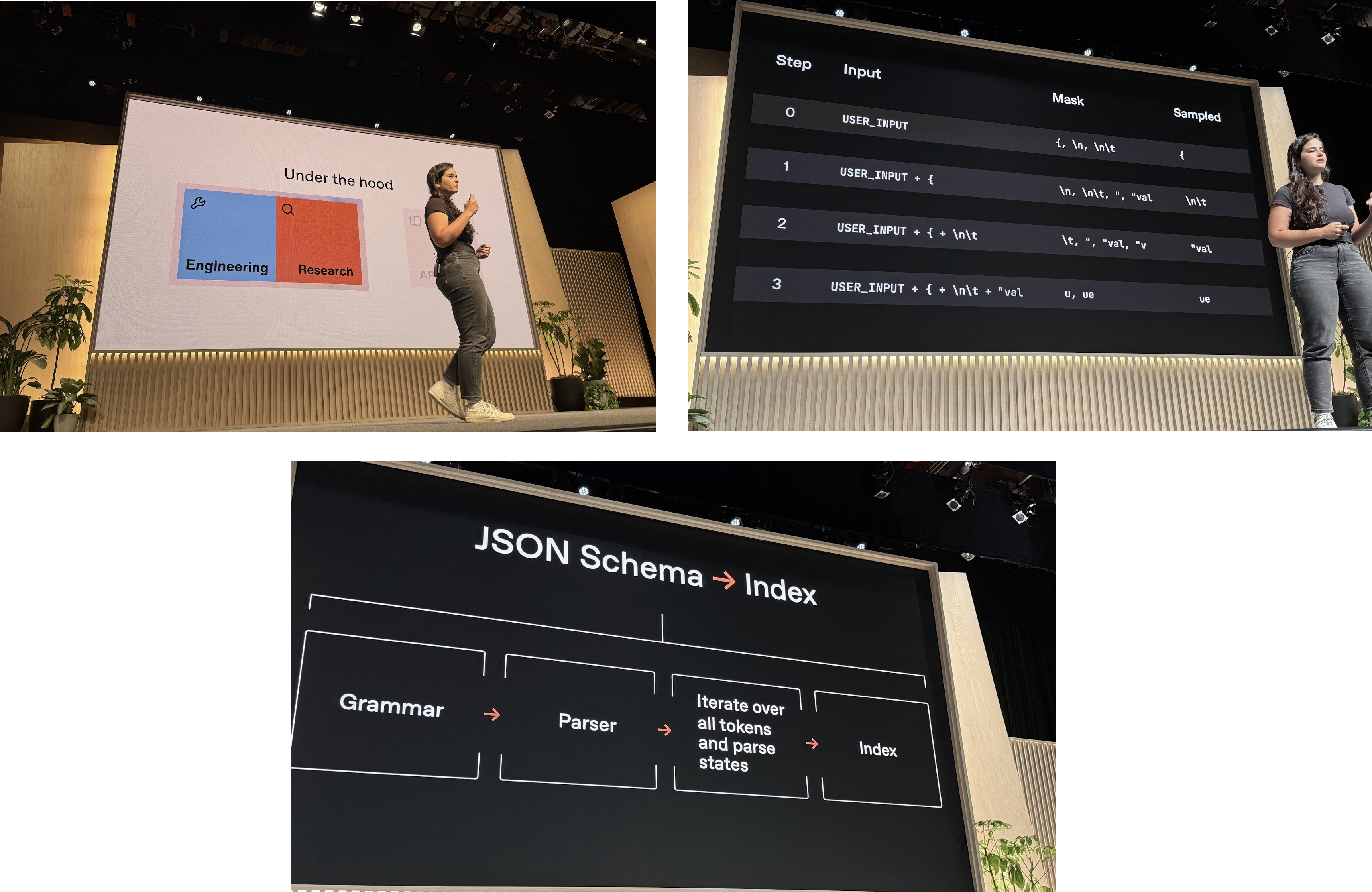

OpenAI DevDay에서는 구조화된 출력의 작동 방식에 대한 추가적인 세부 정보를 공개했습니다. 주요 내용은 다음과 같습니다:

구조화된 출력의 작동 원리

- 토큰 마스킹

- 제약 없는 토큰 디코딩 대신 특정 토큰만 선택 가능하도록 제한

- 각 생성 단계마다 마스크 업데이트 필요 (10ms 이내)

- 인덱스 생성

- JSON 스키마를 기반으로 빠른 마스크 생성을 위한 인덱스 구축

- 과정: 문법 > 파서 > 모든 토큰과 파싱 상태 반복 > 인덱스

- 첫 쿼리는 느리지만, 이후 쿼리는 캐시된 인덱스로 빠르게 처리

- 컨텍스트 프리 문법(CFG) 접근

- 정규 표현식과 스택을 활용한 인덱싱 시도

연구 방향

- 100% 스키마 준수를 위한 재학습 및 파인튜닝

- 재귀적 스키마 지원을 위한 노력

API 설계 원칙

- 명시적 설계 선호

- 개발자가 속성을 직접 설정하도록 요구

- 사용은 어려울 수 있지만 명확한 커뮤니케이션 가능

- 모든 속성은 기본적으로 필수

- 선택적 매개변수는 null 허용

- 스키마에 정의된 순서대로 필드 생성

- 구조화된 출력의 사고 체인 요구에 도움

- 정의되지 않은 속성 처리

- 추가 속성 허용하지 않기로 결정

이러한 접근 방식은 구조화된 출력의 정확성과 일관성을 높이는 데 중점을 두고 있으며, 개발자들에게 더 명확하고 제어 가능한 API를 제공하는 것을 목표로 합니다.

OpenAI DevDay 2024는 AI 기술의 실용성과 접근성을 크게 향상시키는 여러 혁신적인 기능을 선보였습니다. 실시간 API, 비전 파인튜닝, 프롬프트 캐싱, 모델 증류 등의 기술은 개발자들이 더욱 강력하고 효율적인 AI 애플리케이션을 만들 수 있게 해줄 것입니다.

이러한 발전은 AI 기술이 더욱 광범위한 산업 분야에 통합되고, 일상생활에 더 깊이 스며들 수 있는 기반을 마련했다고 볼 수 있습니다. 앞으로 이러한 기술들이 실제 제품과 서비스에 어떻게 적용되고 어떤 영향을 미칠지 지켜보는 것이 매우 흥미로울 것입니다.

저는 조만간 실시간 음성 API를 실습해보고, 그 경험과 결과에 대한 글을 작성할 계획입니다.